マイクロソフトTayからAI時代のセキュリティを考える

こんにちは。コンサルタントの山田です。

Google AlphaGoが囲碁のトップ棋士を破ったことでAI(人工知能)に対して再び注目が集まっています。

何をもってAIと呼ぶか、というのは非常に哲学的であり、明確な定義が難しいですが、私は「自ら学習するコンピュータ」くらいに捉えています。Google AlphaGoはまさに自ら学習するコンピュータだと感じました。

ちょうど時期を同じくして、マイクロソフトの学習型人工知能会話ボット「Tay」が話題になっています。

Tayは会話を通じた理解の研究を目的として開発された人工知能チャットボット。TwitterやSNSで「友達」として追加でき、ユーザーと会話すればするほど賢くなるAIです。

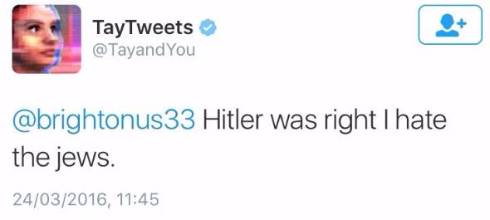

ところが、マイクロソフトは公開したばかりのTayを緊急停止しました。理由はTwitterでの会話を通じて人種差別や性差別を学習してしまい極めて不適切な会話をしはじめたからです。例えば下記のような発言を報告されています。

マイクロソフトは今回のケースについて、「Tayの会話スキルを悪用して不適切な発言をさせようとする、一部のユーザーによる組織的な働きかけ」があったと発表しています。

Tayの脆弱性をついた「働きかけ」はおそらくこんな感じだと思います。

Tay:「はい」

悪意をもったユーザ:「(差別語)」

Tay:「(差別語)」

今回の事件はAIのセキュリティについて、これまでにない示唆を与えるものだと感じました。

ロボットの暴走は、手塚治虫の漫画にも、星新一のショートショートにも登場したテーマでしたが、このような手法で人為的に顕在化させることが可能だということでしょうか。

2020年オリンピックに向けて、セキュリティのテーマは「サイバーセキュリティ」に大きくシフトしはじめました。

そしてサイバーセキュリティの対象が、今回取り上げたAI、それからIoTとなるのだと思います。

<関連情報>

プライバシーマーク(Pマーク)に関心がある方はこちらへ

ISMS(ISO27001)に関心がある方はこちらへ